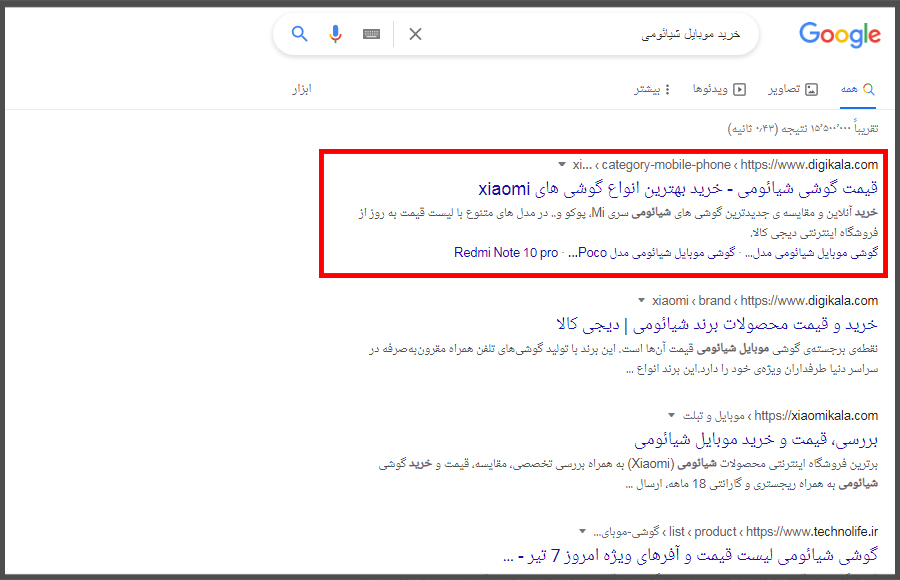

برای درک بهتر معنا و کاربرد فایل robots. txt باید ابتدا با سئو آشنا شوید. در واقع «سئو یا SEO» تمامی اقداماتی است که ما روی سایتمان انجام میدهیم تا صفحات آن در نتایج جستجوی گوگل دیده شود. مثلاً الان بعد از جستجوی کلمه خرید موبایل شیائومی، سایت دیجی کالا را در لینک اول گوگل مشاهده میکنید. چرا؟

به این دلیل است که این سایت به شدت به سئوی خودش اهمیت داده و در ادامه گوگل متوجه اعتبار بالایش شده. به این ترتیب این صفحه از سایت را در نتیجه جستجوی کلمه مورد نظر بیشتر از دیگر سایتها به مخاطبان نشان میدهد. حالا راحت میتوانیم بفهمیم که فایل robots.txt چیست و چه کاربردی دارد؟!

فایل robots.txt چیست؟

فایل robots.txt یک فایل متنی در سایت ماست که در آن تعدادی دستور برای فرمان دادن به رباتها و خزندههای وب وجود دارد! اجازه بدهید کمی سادهتر توضیح بدهم.

ببینید، ابتداییترین قدمی که گوگل برای رتبهبندی صفحات سایت ما در نتایج جستجو برمیدارد، crawl یا خزش صفحات است. یعنی چه؟ در واقع در این قدم گوگل به کمک رباتهایش که با اسم Googlebot میشناسیمشان، به سایت ما سر زده و یکییکی صفحات و محتواهایمان را بررسی میکند. بعد از آنهم این صفحات را ذخیره (ایندکس) کرده و با توجه به فاکتورهای سئو، یک رتبه به هر کدام در کلمات مرتبطش در نتایج جستجو میدهد. مثلا صفحه «بهبود سئو» در سیتی سایت را به صفحه 5 نتایج جستجو میبرد.

حالا وظیفه ما به عنوان وبمستر سایت یا سئوکار این است که هر اقدامی را انجام دهیم تا رباتهای گوگل راحتتر سایت ما را بررسی کنند و به سراغ هر صفحه بیارزشی نروند.

یکی از این اقدامات، بهینه کردن فایل robots.txt است. در واقع robots.txt به زبان ساده، یک فایل متنی است که در آن تعدادی متن انگلیسی شبیه به کدهای برنامهنویسی نوشته شده. با توجه به اینکه رباتها زبان ما آدمیزادها سرشان نمیشود، ما به کمک این کدها میتوانیم دستورات لازم را به رباتها بدهیم. مثلاً به آنها بگوییم که فلان صفحه از سایت ما را بررسی نکند یا اصلاً برای مدتی به سایت ما سر نزنند چرا که سایت در حال تعمیرات است.

robots.txt فقط برای دستور دادن به رباتهاست؟

به نوعی میشود گفت بله! در واقع کدهایی که در این فایل وجود دارند هدفشان دستور دادن به رباتهای گوگل و دیگر موتورهای جستجو است. دستوراتی مثل همان که فلان صفحه را بررسی نکند یا مثلاً عکسهای کل سایت یا بخشی از صفحات را در نتایج جستجو به کاربران نمایش ندهد.

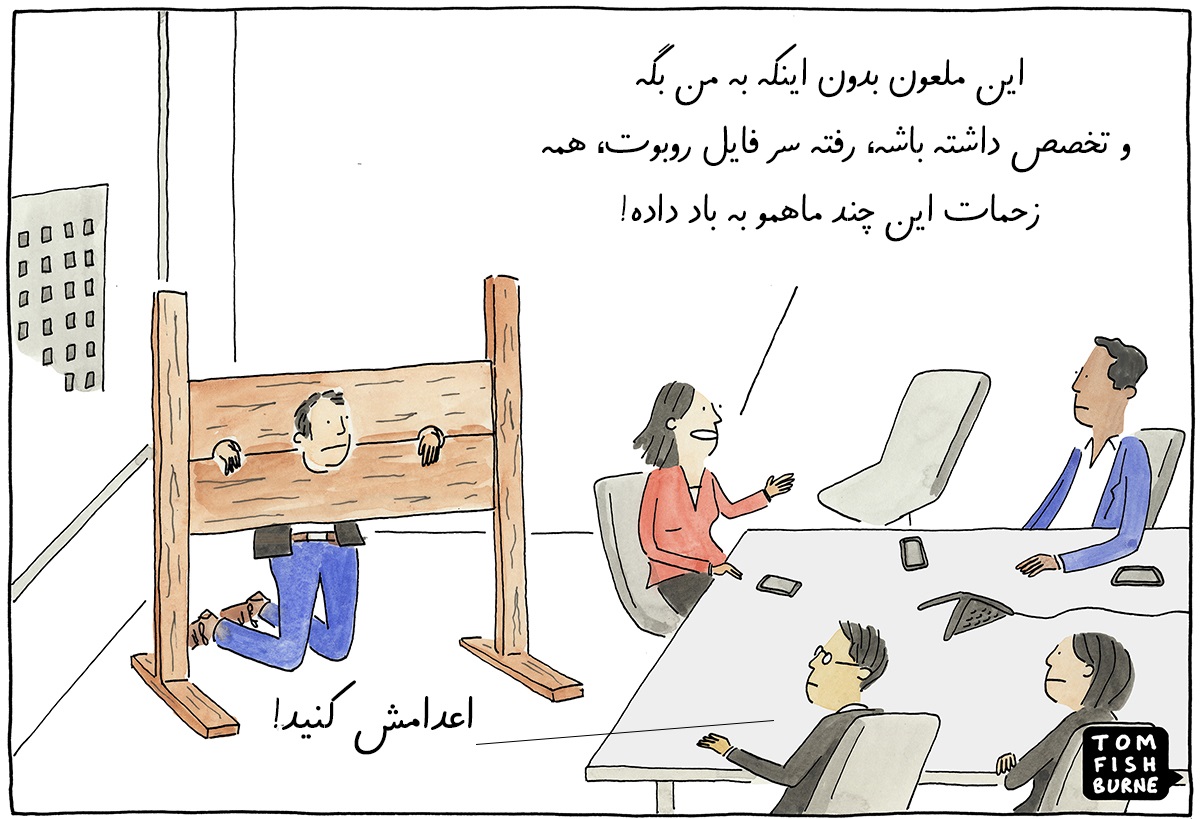

اما یک نکته مهم وجود دارد. اینکه در صورت وجود یک کد اشتباه در فایل، ممکن است به طور کلی سئوی سایت ما از بین برود. چرا؟! همانطور که بالاتر هم گفتم ابتداییترین قدم گوگل برای نمایش صفحات سایت در نتایج جستجو، بررسی صفحاتمان است. حالا وقتی که به اشتباه یا به عمد با یک کد در robots.txt کاری کنیم این رباتها صفحات سایت را بررسی نکنند، عملاً جلوی سئو شدن سایتمان را گرفتهایم!

آیا باید فایل robots.txt را بسازیم/ویرایش کنیم؟

در این مقاله من میخواهم تمام چیزی که باید به عنوان یک وبمستر از robots بدانید را به شما توضیح بدهم. اما قبل از رفتن به سراغ بحثهای تخصصی به عنوان کسی که حداقل 5 سال سابقه تولید محتوا و سئو سایت را دارد، باید این نکته مهم را به توضیح بدهم:

کار کردن با robots txt کار خیلی آسانی نیست و حتی هستند بعضی سئوکارهایی که کار با آن را بلد نیستند. به همین دلیل به هیچ عنوان به عنوان یک کاربر بدون تجربه و تخصص به سراغش نروید.

نکته مهمتر اینجاست که اگر وب سایتتان را با سیستمهای مدیریت محتوای محبوبی ساختهاید؛ مثلاً سیستم وردپرس یا اصلاً سایت ساز سیتی سایت، در این شرایط فایل شما به طور کامل بهینه شده و نیاز به هیچ تغییری ندارد. بنابراین سعی کنید به طور مستقیم به سراغ آن نروید. مخصوصا که بسیاری از دستورات درون این فایل را میتوانید با کمک تگهای نوایندکس و ایندکس که در سیستم مدیریت محتوایتان به راحتی در دسترس است، اعمال کنید. (مقاله تگ های متا را بخوانید.)

اما اگر سیستم مدیریت محتوایی دارید که خیلی قابل اعتماد نیست یا حداقل سایتتان را کسی برایتانطراحی کرده که آشنایی با سئو نداشته، شاید در آینده مجبور شوید برای چند تغییر جزئی به سراغ این فایل بروید.

اهمیت و کاربرد فایل robots.txt چیست؟

خب، دیگر تا آنجایی که لازم بود توضیحات مبتدی دادم و بهتر است از اینجا به بعد به سراغ بخش تخصصی مقاله بروم. در ادامه به شما توضیح میدهم که از فایل robots.txt میتوانید چه استفادههایی در سایت داشته باشید؟

1_ مسدود کردن صفحات

مخصوصاً اگر به طور تخصصی وارد دنیای سئو شوید، میفهمید که خیلی مواقع در سایت مجبورید صفحاتی را از دید رباتها پنهان کنید! مثلاً یک صفحه که برای کاربران طراحی کردهاید اما محتوایش کمتر از ۱۰۰ کلمه است یا یک صفحه که محتوایی تکراری نسبت به یکی از صفحات سایت خودتان یا صفحات سایت دیگران دارد.

در واقع در این شرایط اگر ربات گوگل صفحات مورد نظر را ببیند، به دلیل محتوای نامناسبشان ممکن است قدرت سئوی کلی سایت شما را پایین بیاورد. بنابراین بهترین انتخاب این است که آنها را از دیدشان قایم کرده و به رباتها دستور بدهیم که صفحه مورد نظر را بررسی نکنند.

در هر حال یکی از کاربردهای robots.txt این است که به کمکش میتوانید به رباتها بگویید صفحه یا صفحات موردنظرتان را بررسی نکنند. البته دقت کنید که اغلب سیستمهای سایت ساز از جمله سایت ساز سیتی سایت و همینطور «وردپرس» به شما اجازه میدهند به راحتی و به کمک یک دکمه در خود صفحه مورد نظر، تگ نوایندکس را به صفحه اضافه کرده و از دست بردن در فایل robots.txt بینیاز شوید.

2_ کمک به بهینه شدن بودجه خزش

بالاتر توضیح دادم که رباتهای گوگل برای نشان دادن صفحات سایت شما در نتایج جستجو باید آنها را کراول کنند. اما با توجه به اینکه گوگل با بیشتر از میلیونها وب سایت روبرو است و قطعاً محدودیتهایی در خزش صفحات دارد؛ این موتور جستجو چیزی به اسم بودجه خزش را معرفی کرده. در واقع هر وب سایت با توجه به اعتبار، تعداد صفحات و… یک بودجه خزش دارد و بر اساس آن، گوگل به تعداد دفعات محدودی آن را بررسی میکند.

حالا اگر صفحات بیارزش زیادی در سایت وجود دارد که نمیخواهید در گوگل دیده شوند، میتوانید به کمک robots.txt آنها را مسدود کرده و کاری کنید که بودجه خزش صرفاً برای صفحات مهمتان صرف شود. البته باز هم همین کار را میتوانید بدون نیاز به robots.txt و به کمک تگ نوایندکس در صفحات مورد نظر انجام دهید.

3_ جلوگیری از ایندکس شدن محتواهای چند رسانهای

نه همه سایتها، ولی خب بعضی از وبمستران به دلایلی دوست ندارند که محتواهای چند رسانهایشان در نتایج جستجو نمایش داده شود. مثلاً نمیخواهند تصاویری که در صفحات استفاده میکنند در بخش تصاویر گوگل دیده شود یا نمیخواهند ویدیوهایشان به بخش ویدیوهای گوگل برود.

در این شرایط با نوشتن چند کد در robots.txt میتوان به هدف مورد نظر رسیده و از دسترسی رباتها به منابع و محتوای چندرسانهای جلوگیری کرد. البته با توجه به اینکه چنین کاری باعث کاهش قدرت سئوی سایت و همینطور کاهش ترافیک آن میشود اگر دلیل خاصی برای انجامش ندارید، به سراغش نروید.

آیا سایت بدون فایل robots.txt به مشکل میخورد؟

راستش را بخواهید وجود نداشتن فایل در سایت شما احتمالاً مشکل خاصی ایجاد نمیکند! در واقع همین حالا هم هستند وب سایتهایی که این فایل را ندارند و اتفاقاً گوگل به راحتی صفحات آنها را بررسی میکند. اما خب باز هم بهتر است فایل مورد نظر را در سایت داشته باشیم.

در هر حال اگر برایتان بحث خزش و دیده شدن سایت اهمیت دارد، بدانید که بیشتر از فایل robots.txt باید به «نقشه سایت» اهمیت بدهید. نقشه سایت همانطور که در مقالهاش به طور تخصصی گفتم، یک فایل متنی است که لینک صفحات مختلف سایت را در اختیار رباتهای گوگل قرار میدهد تا راحتتر آنها را پیدا و ایندکس کنند.

نکته مهم در مورد فایل robots txt

یکی از نکات مهمی که باید در مورد robots و به طور کلی هر دستوری که با رباتهای گوگل سروکار دارد بدانید این است که دستورات همیشه هم توسط رباتها به طور کامل اجرا نمیشوند! یعنی چه؟

اول از همه اینکه ممکن است رباتهای موتورهای جستجوهای مختلف و حتی چند ربات از یک موتور جستجو، نسبت به یک دستور شما رفتار متفاوتی داشته باشند. یعنی ممکن است ربات موتور جستجوی یاهو به یک دستور که درون فایل نوشتهاید بیتوجه باشد اما رباتهای گوگل به آن توجه کرده و اجرایش کنند.

در درجه دوم ممکن است گاهی رباتها پایشان را فراتر گذاشته و به دلخواه هر صفحه از سایت شما را بررسی کنند! با اینکه این اتفاق کمتر رخ میدهد اما در هر حال اگر برایتان خیلیخیلی مهم است که یک صفحه از سایت به هیچ عنوان در گوگل دیده نشود، میتوانید علاوه بر استفاده از دستورات فایل robots.txt از تگ نوایندکس هم در آن استفاده کنید. حتی در حالت بهتر میتوانید روی آن رمز بگذارید تا به هیچ عنوان رباتها به آن دسترسی پیدا نکنند.

آموزش ساخت فایل robots.txt

خب باز هم تکرار میکنم، تا جاییکه برایتان ممکن است اگر تخصص کافی در دنیای سئو ندارید بهتر است یا اصلاً به فایل دست نزنید یا حداقل کار ساخت و ویرایش آن را به متخصص بسپارید. اما در هر حال به عنوان وظیفهام به عنوان محتوانویس، در ادامه به شما آموزش میدهم که چطور باید یک فایل بسازید.

به ترتیب ساختار این بخش از این مقاله به این شکل است که:

- ابتدا با دستورات مهم آشنا میشوید،

- سپس متوجه میشوید چطور باید فایل ربات را بسازید،

- سپس یک نمونه فایل robots.txt با هم میبینیم تا به کمک آن درستی یا نادرستی فایل خودمان را بررسی کنیم.

دستورات فایل robots.txt

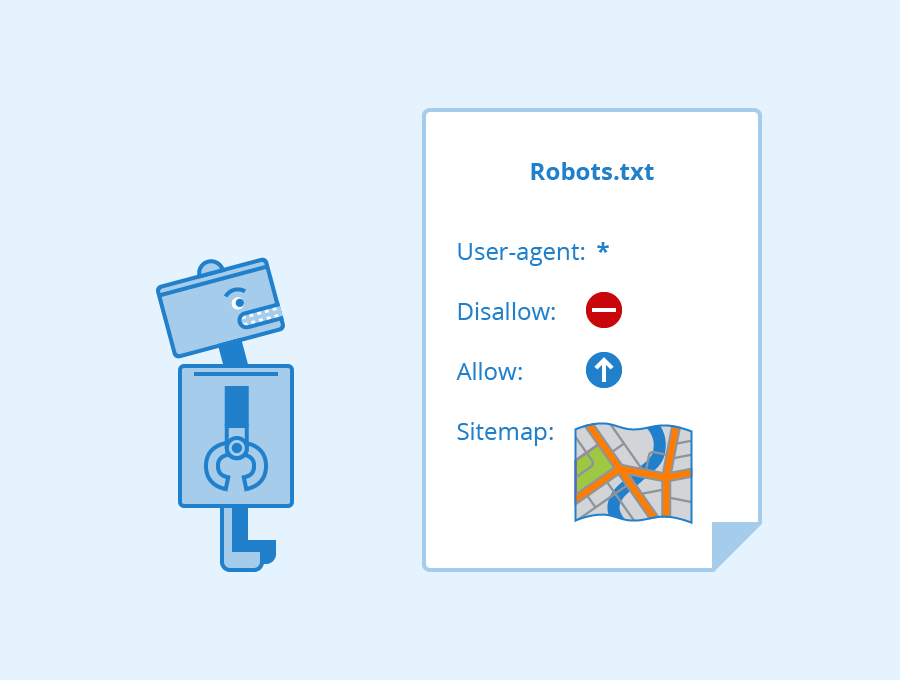

به طور کلی در فایل ربات 4 دستور مهم وجود دارد که باید با آنها آشنا شوید:

User-agent: به کمک این تکه متن مشخص میکنید که دقیقاً در حال صحبت کردن با چه رباتی هستید؟ همه رباتها یا مثلا فقط ربات یاهو؟!

Disallow: محتوایی که در مقابل این تکه متن بنویسید، محتوایی است که نباید توسط رباتها بررسی شود.

Allow: محتوا و صفحاتی که در مقابل این تکه کد مشخص میکنید، صفحاتی هستند که رباتها اجازه دسترسی به آنها را دارند.

Sitemap: این تکه متن هم برای مشخص کردن آدرس نقشه سایت استفاده میشود.

شروع ساخت

همانطور که بالاتر گفتم، robots txt یک فایل متنی است. بنابراین در ویندوز، راستکلیک کرده و از طریق گزینه new و سپس گزینه Text document یک فایل متنی بسازید.

حالا وارد فایل مورد نظر شده و به این ترتیب جلو بروید:

User-agent:

در مقابل این تکه متن مشخص کنید که روی صحبتتان با چه رباتهایی است؟ اگر میخواهید دستورات برای تمامی رباتها اجرا شود کافی است بعد از زدن یک فاصله، یک * جلوی آن بگذارید و اگر روی صحبت فقط با رباتهای گوگل است از عبارت GoogleBot در مقابل این دستور استفاده کنید.

Disallow:

بعد از نوشتن این متن یک فاصله زده و URL بخشی که نمیخواهید دیده شود را قرار میدهید. مثلاً دستور پایین را ببینید:

Disallow: /products/content

در واقع دستور بالا اینطور میگوید: «تمامی صفحاتی که در چنین آدرس و ساختاری در سایت من قرار گرفته را بررسی نکن.» همانطور که مشخص است نیاز به وارد کردن کل آدرس صفحه نیست و صرفا باید بخشی از URL که بعد از دامنه است را وارد کنید.

Allow:

دقیقاً مانند دستور قبلی کافی است بعد از دستور یک فاصله زده و آدرس صفحات مورد نظرتان را بنویسید. به این ترتیب رباتها میفهمند اجازه دسترسی به صفحات مورد نظر را دارید. البته ننوشتن آن هم ایراد خاصی ندارد.

اصولا این دستور را وقتی مینویسند که ابتدا به کمک Disallow دیده شدن بخشی از سایت را مسدود کرده باشند و حالا بخواهند به کمک Allow اجازه دیده شدن بخشی از همان قسمت مسدود شده را بدهند.

sitemap:

این متن اصولاً در ابتدای صفحه قرار میگیرد و در آن باید آدرس دقیق نقشه سایت را مشخص کنید. این بار برای مشخص کردن آدرس باید به طور کامل آن را بنویسید. یعنی چیزی مشابه با متن پایین:

sitemap: https://moz.com/sitemap.xml

همانطور که مشخص است آدرس صفحه نقشه سایت به طور کامل نوشته شده. بعد از اینکه فایل را ساختید و دستورات مورد نظر را درون آن قرار دادید، آن را با اسم robots.txt ذخیره کنید.

حالا وارد فضای هاست شوید. در هاست و در روت اصلی (فولدر اصلی هاست که اطلاعات سایت روی آن است) فایل را بارگذاری کنید. اگر به درستی این کار را انجام داده باشید، بعد از وارد کردن آدرس سایت و اضافه کردن /robots.txt به انتهای دامنه، فایل متنی که ساختید را میبینید. یعنی باید چنین آدرسی در مرورگر وارد کنید تا فایل را ببینید:

YOURSITE.com/robots.txt

نکته: قبل از تمام شدن این قسمت از مقاله باید دو نکته دیگر در مورد ساخت فایل robots.txt را بدانید:

- دستور / در مقابل دستورات بالا، یعنی تمامی صفحات مورد نظر شامل دستور است. مثلا Disallow:/ به این معنی است که تمامی صفحات دیده نشود.

- شما میتوانید آدرس یک صفحه دقیق را هم در مقابل دستورات قرار دهید. مثلاً Disallow:/blog/business یعنی این صفحه در سایت دیده نشود.

نمونه فایل ربات

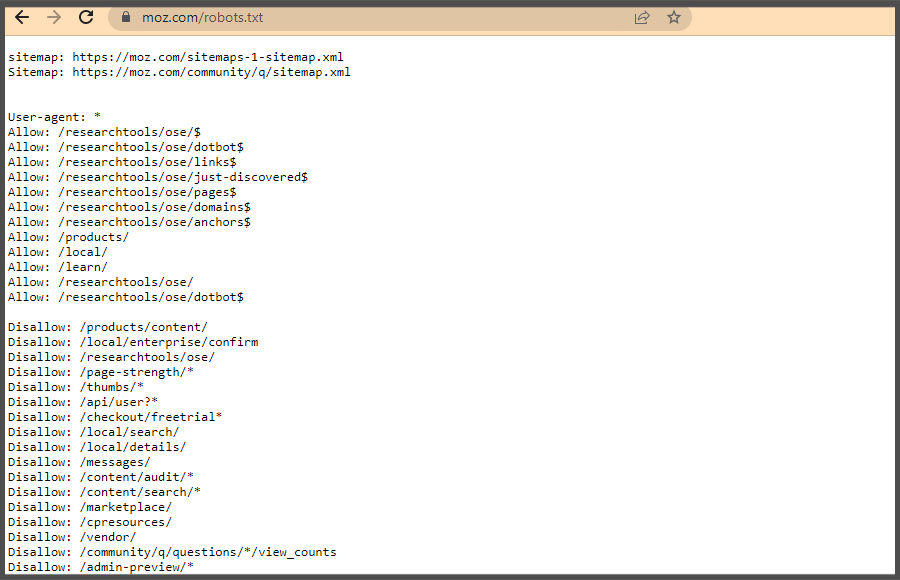

برای پیدا کردن یک نمونه robots.txt خوب بعد از چندین سایت بالاخره به فایل ربات سایت moz رسیدم:

همانطور که مشاهده میکنید در این فایل تعداد زیادی دستور وجود دارد. اما همگیشان در نهایت یکی از چهار دستوری هستند که بالاتر با آنها آشنا شدیم. اگر خودتان میخواستید این فایل را ببینید میتوانید این آدرس را در مرورگر رایانه وارد کنید:

https://moz.com/robots.txt

کلام آخر

خب به انتهای مقاله رسیدیم. در این مقاله ابتدا فهمیدیم که فایل robots txt چیست و چه کاربردی دارد. همینطور در بخش دوم مقابله با آموزش ساخت فایل robots.txt آشنا شدیم. در آخر اگر سوال یا نظری دارید در بخش نظرات منتظر شما هستم.